Содержание страницы

- 1 Файл robots.txt и его написание.

- 2 Для наглядности привожу файл robots.txt моего блога.

- 2.1 А ТЕПЕРЬ МОЯ НЕБОЛЬШАЯ РЕМАРКА К ДАННОЙ СТАТЬЕ ПРО ФАЙЛ ROBOTS.TXT.

- 2.2 Расширенный вариант robots.txt для wordpress (отдельные правила для Google и Яндекса)

Файл robots.txt и его написание.

Файл robots.txt необходим для любого вэб-ресурса, так как с его помощью осуществляется управление над всеми поисковыми системами (роботами), в чем, собственно и состоит предназначение robots.txt.

Любой пользователь интернета сможет попасть на ваш сайт, уважаемый читатель, лишь в том случае, если ваш вэб-ресурс будет проиндексирован. А для этого надо, чтобы на вашем сайте побывал поисковый робот, который должен проанализировать страницы и добавить в свою поисковую базу. И вот только после этого, только тогда такие страницы смогут быть допущены к появлению в поисковой выдаче.

Но на вашем сайте может быть бессчетное число всевозможных ненужных документов (например, чисто служебная информация, копии каких-либо документов и т.д.), которые поисковому роботу загружать в свою базу для поиска ни к чему.

И вот тут-то и начинает свою работу файл robots.txt.

Файл robots.txt указывает поисковым роботам какие параметры на сайте нужно индексировать, а какие – нет. Этот файл создается самим владельцем сайта, причем создается он в текстовом документе с расширением txt (обыкновенный блокнот) в нижнем регистре. Уже готовый файл заливается на хостинг в корневую папку publir_html. Затем делается проверка – загрузился ли этот файл, работает ли этот файл.

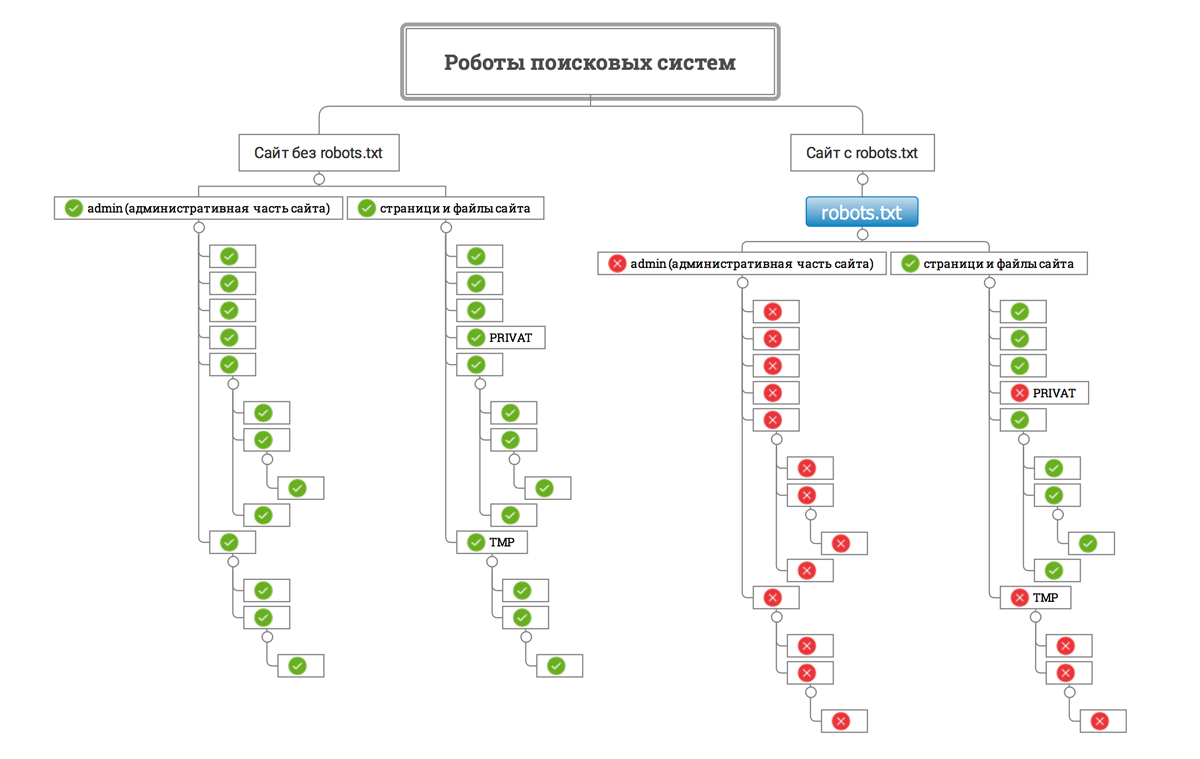

Так роботы поисковых систем видят сайт с файлом robots.txt и без него:

О том, как проверить (есть ли он, или его нет на сайте) файл robots.txt я уже писал в одной из статей своего блога. Для интереса, можете прямо на моем блоге проверить наличие robots.txt, посмотреть, как он выглядит.

Google установил ограничение по размеру файла robots.txt — он не должен весить больше 500 Кб.

При обработке правил в файле robots.txt поисковые роботы получают одну из трех инструкций:

- частичный доступ: доступно сканирование отдельных элементов сайта;

- полный доступ: сканировать можно все;

- полный запрет: робот ничего не может сканировать.

При сканировании файла robots.txt роботы получают такие ответы:

- 2xx — сканирование прошло удачно;

- 3xx — поисковый робот следует по переадресации до тех пор, пока не получит другой ответ. Чаще всего есть пять попыток, чтобы робот получил ответ, отличный от ответа 3xx, затем регистрируется ошибка 404;

- 4xx — поисковый робот считает, что можно сканировать все содержимое сайта;

- 5xx — оцениваются как временные ошибки сервера, сканирование полностью запрещается. Робот будет обращаться к файлу до тех пор, пока не получит другой ответ.Поисковый робот Google может определить, корректно или некорректно настроена отдача ответов отсутствующих страниц сайта, то есть, если вместо 404 ошибки страница отдает ответ 5xx, в этом случае страница будет обрабатываться с кодом ответа 404.

Для наглядности привожу файл robots.txt моего блога.

User-agent: * Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /feed/ Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */comments Disallow: /category/*/* Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /?s= User-agent: Yandex Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /feed/ Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */comments Disallow: /category/*/* Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /?s= Host: name-site.ru Sitemap: http://name-site.ru/sitemap.xml.gz Sitemap: http://name-site.ru/sitemap.xml # start (J) ExR User-Agent: * Disallow: /jexr/ # end (J) ExR # start (J) ExR User-Agent: * Disallow: /jexr/ # end (J) ExR # start (J) ExR User-Agent: * Disallow: /jexr/ # end (J) ExR

А теперь мне хотелось бы немножко подробнее рассмотреть некоторые составляющие файла robots.txt (что каждая из них означает). Кстати, если уж быть точным, то правильно составляющую называют директива (я не буду умничать, я буду так и называть).

Итак, рассмотрим правила написания в файле robots.txt.

С самого начала файл robots.txt определяет, – для каких именно роботов поисковых систем будет составлена директива.

User-agent: *

Директива User-agent прописывает именно поисковый робот, на данный момент известно 302 поисковых робота. Чтобы не прописывать всех по отдельности, стоит использовать звёздочку: где звёздочкой указано, что это любой робот любой поисковой системы. Если же файл robots.txt создается под определенную поисковую систему, то в этом месте она должна быть прописана.

Например, User-agent: Yandex, где дается указание именно для поискового робота Yandex. Для определенной поисковой системы у поискового робота есть свое определенное название-имя (например, для Гугла будет Googlebot). Для сведения хочу сказать, что у Яндекса работает большое число роботов с разными предназначениями индексации (например, для индексации страниц используется YandexBot, для индексации картинок – YandexImages, и т.д.). Конкретно прописанная директива Yandex в robots.txt будет определенно относиться ко всем роботам поисковой системы Яндекс.

А теперь, непосредственно, про директивы, которые подразделяются в файле robots.txt на разрешающие и запрещающие. Они выглядят так: Allow (разрешающая директива), Disallow (запрещающая директива).

Например:

User-agent: *

Disallow:

где позволяется всем роботам любой поисковой систем индексация содержимого всего вэб-ресурса. Если же после директивы пустое место и после двоеточия ничего не прописано, то, никаких запретов не подразумевается ни на что.

User-agent: *

Disallow: /

где знаком слэш показано ко всему вэб-ресурсу допуск полностью блокирован.

Например:

User-agent: *

Disallow: /wp-admin/

где запрещается индексировать лишь директорию wp-admin (все файлы находящиеся в директории wp-admin), но если будет прописано /wp-admin, то индексация будет проводиться.

User-agent: *

Disallow: /wp-admin

в этом случае запрещена индексация всего того, что будет начинаться со слова wp-admin (запрет содержания директории wp-admin и файла /wp-admin).

User-agent: *

Disallow: //wp-login.php

где запрещена индексация для файла /wp-login.php (в том случае, если, этот файл имеется в корневой директории).

А ТЕПЕРЬ МОЯ НЕБОЛЬШАЯ РЕМАРКА К ДАННОЙ СТАТЬЕ ПРО ФАЙЛ ROBOTS.TXT.

Сразу скажу – идеального варианта для файла robots.txt нет. Даже на блогах известных СЕОшникоа данный файл не одинаков. Лично я знаю два варианта файла robots.txt. На некоторых крутых блогах стоят два варианта файла robots.txt, причем один из них, как обычно – файл robots.txt для всех поисковых систем, а другой – конкретно под Яндекс, т.е Яндекс любит, чтобы ему уделялось особо-персональное внимание (вот такая ца-ца этот Яндекс).

Расширенный вариант robots.txt для wordpress (отдельные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site-name.ru/sitemap.xml

Sitemap: http://site-name.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site-name.ru

Вот, пожалуй, и все уважаемый читатель. Теперь вы знаете для чего необходим файл robots.txt, узнали о его роли для продвижения сайта, а также имеете представление о том, как составляется файл robots.txt.

Успехов во всем!!!

Автор статьи: Олег Поздеев

Блог автора: infopero.ru

Свежие комментарии